研究方向

课题组的主要研究方向包括融合感知、智能决策。中国有世界上最复杂的人车道路交通环境,其准确可靠的感知是高级别自动驾驶实现突破的关键瓶颈技术。课题组重点研究以地图为超级感知容器构建车-路-云多模态感知融合理论,建立中国标准自动驾驶AI感知系统,实现中国复杂场景下的融合一体化准确感知认知。同时在感知认知的基础上,探索自动驾驶的安全决策机理,研究深度强化学习等在线学习理论,实现自动驾驶决策能力的自进化与迁移。

部分研究成果如下:

Ÿ 融合深度学习网络的智能传感器技术

针对自动驾驶场景动态多变、干扰严重等现实困难,研究深度学习等人工智能算法。

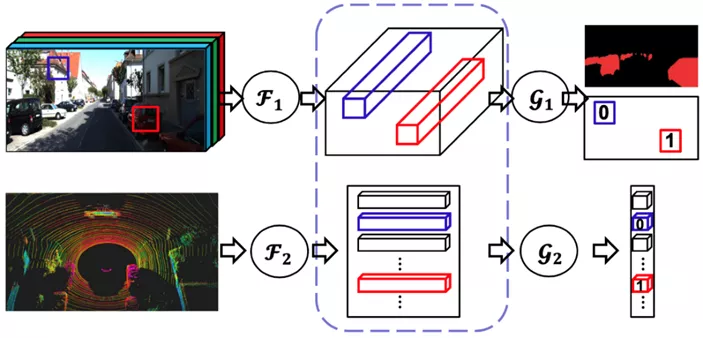

提出了基于多传感器深度融合的目标检测方法,挖掘异构传感器数据所包含的特征信息,提升了车载传感器的智能化程度,所提出的SGFNet在KITTI 3D车辆验证集中取得最高检测准确率。

Ÿ 增强感知与决策的自动驾驶地图及其众包更新技术

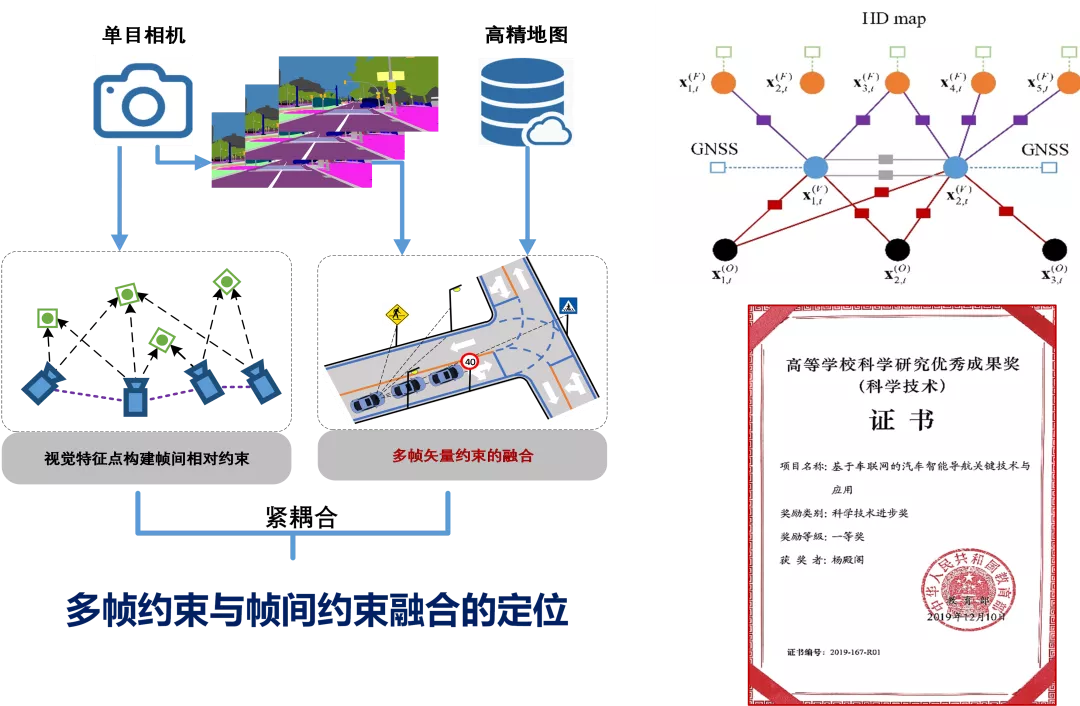

针对自动驾驶感知、定位、决策的需求,提出了多层可扩展的自动驾驶地图模型。

面向众包视频数据,提出了基于单目相机地图匹配的高精度定位技术,支撑了众包更新应用,主导自动驾驶地图与定位工作组,推动相关标准。成果获中国汽车工程科技进步奖特等奖(2019年)。

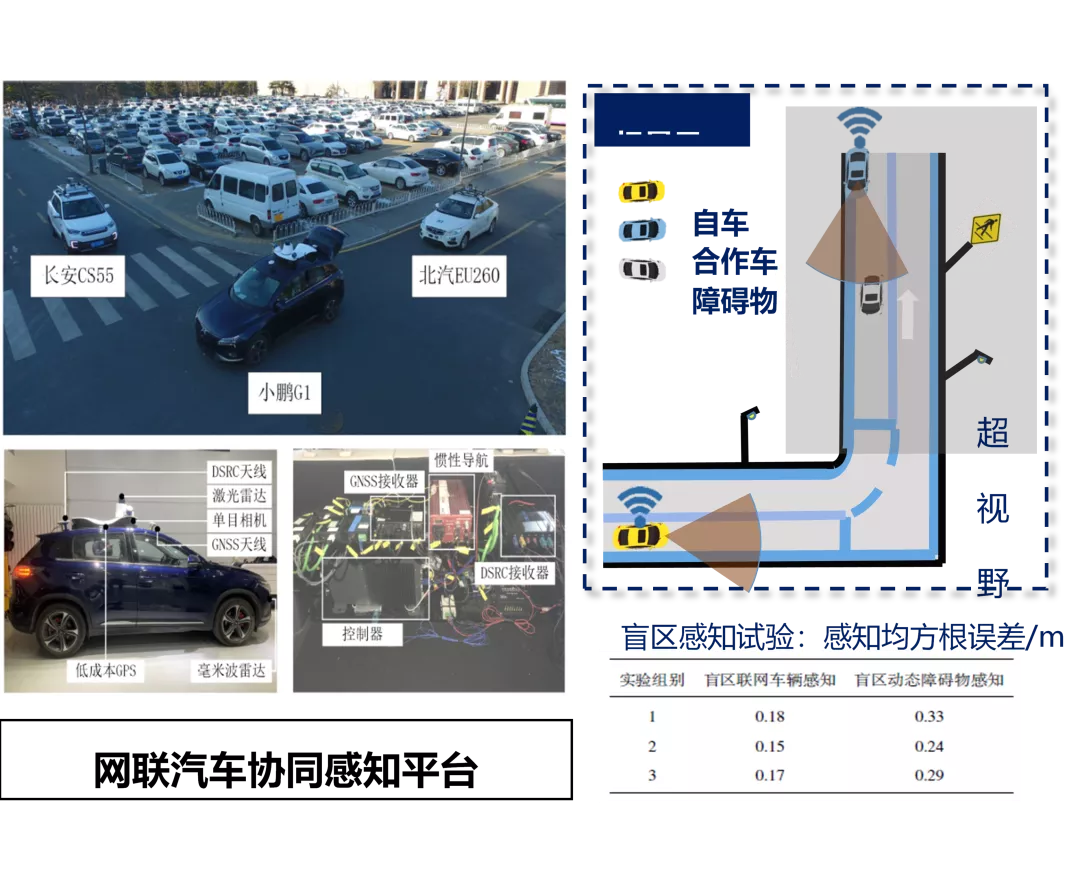

Ÿ 面向超视距无盲区协同感知的地图感知容器技术

针对单车感知能力有限的难点问题,提出了基于高精度地图的感知容器技术,充分利用多车感知信息实现360度无盲区全息感知,构建了基于滑动时间窗的多车协同感知概率融合框架,对多车异步失序信息进行跟踪融合。相关研究获得教育部科技进步一等奖(2019)。

Ÿ 行人交警行为手势的语义理解技术

人是道路交通系统的重要组成要素,通过具有特定语义的交通指挥手势,可实现智能交通系统下的人车交互。

数据集示例及人体姿态估计算法效果

由于运动车载视角下的交通场景复杂多变、道路使用者的外观丰富多样、手势幅频不确定性高,实现手势语义的准确快速理解面临着诸多难题。

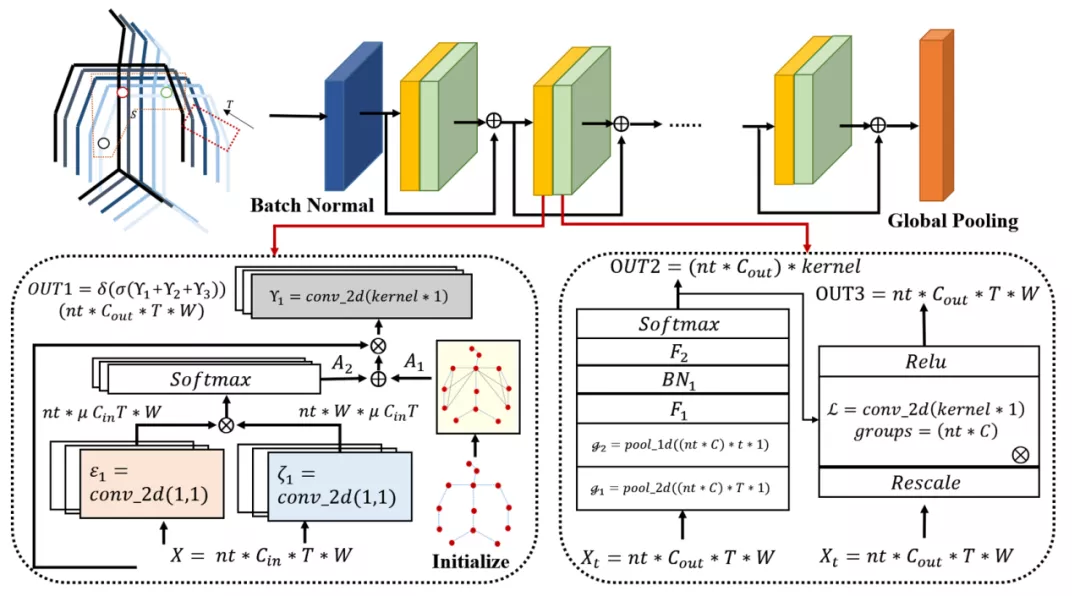

基于二维姿态特征和长短时记忆网络的交通指挥手势识别框架

基于二维关节点几何特征和空间共现性特征的朝向和手势联合识别框架

基于三维姿态特征和时空图卷积网络的交通指挥手势识别框架

同时充分利用具备外观不变性的人体姿态特征,提出基于多层次二维及三维人体姿态特征的交通指挥手势识别方法。成果用于北京冬奥首钢园区功能示范。

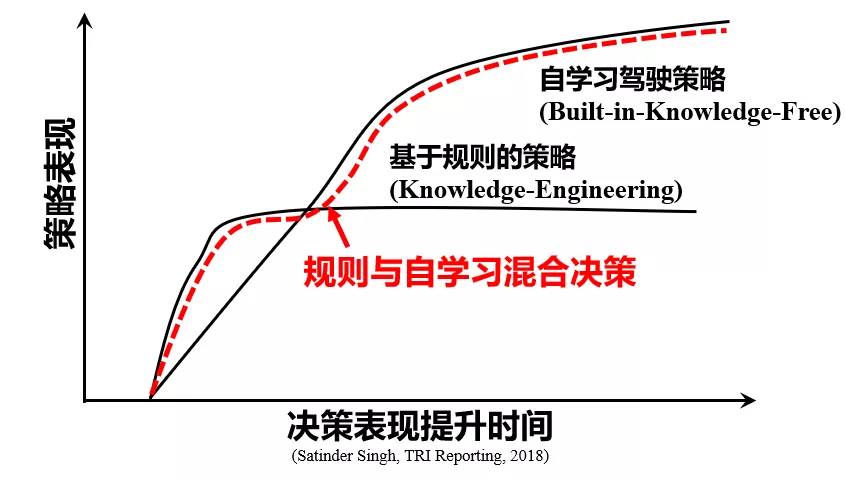

Ÿ 规则与自学习混合的自动驾驶智能决策方法研究

具有自学习能力的自动驾驶决策方法面临其黑盒属性与车辆驾驶可信赖性需求之间的矛盾。

针对这一难题,提出规则与自学习混合决策方法。使自动驾驶汽车具有自学习能力的同时具有可信赖的驾驶表现。

成果应用于北京首钢冬奥园区自动驾驶示范,在由谷歌、丰田等公司组织的CARLA仿真挑战赛上获决策组第2/68名。

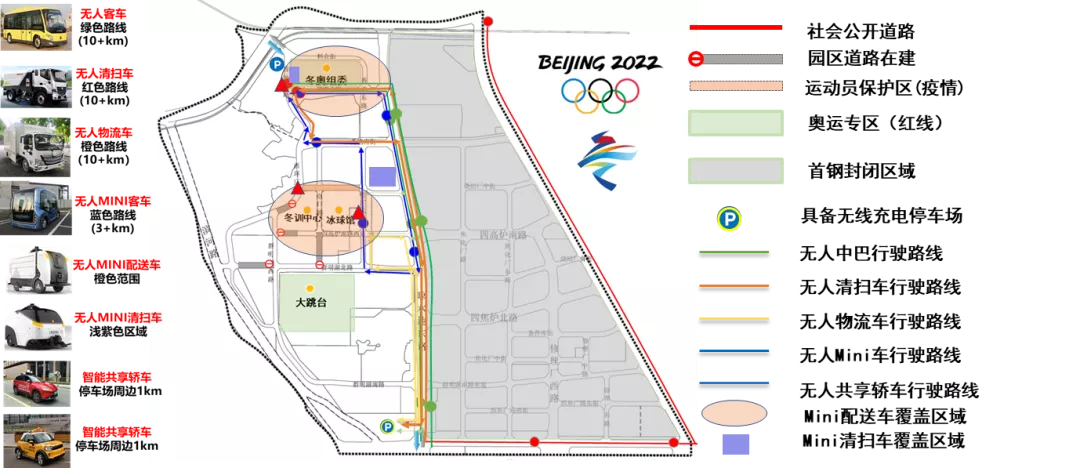

Ÿ 北京市科委冬奥重点专项自动驾驶应用示范

牵头北京市科技计划冬奥重点项目“全天候多车型自动驾驶技术开发及首钢园区功能示范”。开发7种车型(12辆车)在首钢园区进行 L4 级自动驾驶示范应用。

七种自动驾驶车型首钢园区应用示范

并将核心技术与成果应用于2020服贸会无人驾驶体验,接待1512名体验者,接待央视、北京电视台等15多家媒体,以及奥组委领导们体验无人车,获得了一致好评。

English

English